150多名领先的人工智能(AI)研究人员、伦理学家和其他人签署了一封公开信,呼吁生成式人工智能(genAI)公司提交对其系统的独立评估,缺乏评估导致了对基本保护的担忧。

这封信由麻省理工学院、普林斯顿大学和斯坦福大学的研究人员起草,呼吁对基因模型的善意研究提供法律和技术保护,他们说这阻碍了有助于保护公众的安全措施。

这封信及其背后的一项研究是在近20名教授和研究人员的帮助下完成的,他们呼吁为基因产品的独立评估建立一个法律上的“安全港”。

这封信被寄给了OpenAI、Anthropic、谷歌、meta和Midjourney等公司,并要求他们允许研究人员调查他们的产品,以确保消费者免受偏见、涉嫌侵犯版权和未经同意的亲密图像的影响。

“对已经部署的人工智能模型进行独立评估,被广泛认为是确保安全、保障和信任的关键,”负责这封信的两名研究人员在一篇博客文章中写道。“人工智能模型的独立红队研究发现了与低资源语言、绕过安全措施和各种越狱有关的漏洞。

他们说:“这些评估调查了一系列通常意想不到的模型缺陷,这些缺陷与滥用、偏见、版权和其他问题有关。”

去年4月,一份技术专家名人录呼吁人工智能实验室至少在六个月内停止训练最强大的系统,理由是“对社会和人类构成严重风险”。

这封公开信现在有超过3100人签名,包括苹果联合创始人史蒂夫·沃兹尼亚克(Steve Wozniak);科技领袖们特别提到了总部位于旧金山的OpenAI实验室最近宣布的GPT-4算法,称该公司应该停止进一步的开发,直到监管标准到位。

这封最新的信称,人工智能公司、学术研究人员和民间社会“一致认为,生成式人工智能系统构成了显著的风险,对这些风险的独立评估是问责制的一种基本形式。”

联名者包括来自常春藤盟校和其他知名大学(包括麻省理工学院)的教授,以及hug Face和Mozilla等公司的高管。该名单还包括研究人员和伦理学家,如民主与技术中心的研究主任达纳拉杰·塔库尔,以及人工智能风险与脆弱性联盟的主席Subhabrata Majumdar。

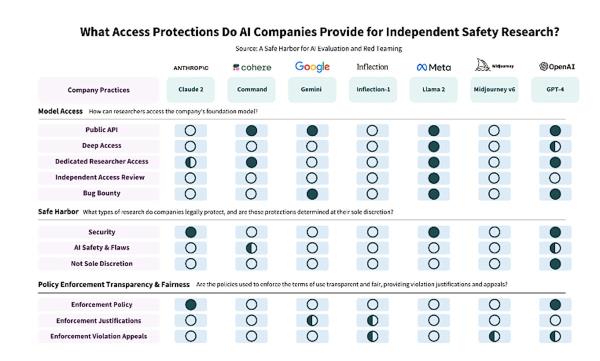

虽然这封信承认,甚至赞扬了一些基因制造商有特殊的程序,可以让研究人员访问他们的系统,但它也指出,他们对谁能或不能看到他们的技术持主观态度。

研究人员特别指出,人工智能公司Cohere和OpenAI是这一规则的例外,“尽管受保护活动的范围仍然有些模糊。”

在提供适当的漏洞披露(没有明确的法律承诺)的情况下,coherence允许“对API和对抗性攻击进行有意的压力测试”。OpenAI将其安全港扩大到包括“模型漏洞研究”和“学术模型安全研究”,以回应我们的提案的早期草案。

在其他情况下,人工智能公司已经暂停了研究人员的账户,甚至改变了他们的服务条款,以阻止某些类型的评估。研究人员表示,“剥夺独立研究人员的权力不符合人工智能公司的自身利益。”

这封信认为,调查基因人工智能产品的独立评估人员担心账户被暂停(没有上诉的机会)和法律风险,“这两者都可能对研究产生寒蝉效应”。

为了帮助保护用户,签署国希望人工智能公司为研究提供两级保护:

- 一个合法的避风港,以确保诚信独立的人工智能安全、保障和可信度研究引入完善的漏洞披露。

- 企业承诺通过使用独立审稿人来调节研究人员的研究,从而实现更公平的获取途径评估应用程序。

《计算机世界》联系了OpenAI和谷歌寻求回应,但两家公司都没有立即发表评论。

本文来自作者[藏士俊]投稿,不代表聚慧融智立场,如若转载,请注明出处:https://cn.ictconsultant.cn/zlan/202505-1236.html

评论列表(4条)

我是聚慧融智的签约作者“藏士俊”!

希望本篇文章《专家呼吁人工智能公司透明化安全审查》能对你有所帮助!

本站[聚慧融智]内容主要涵盖:国足,欧洲杯,世界杯,篮球,欧冠,亚冠,英超,足球,综合体育

本文概览: 150多名领先的人工智能(AI)研究人员、伦理学家和其他人签署了一封公开信,呼吁生成式人工智能(genAI)公司提交对其系统的独立评估,缺乏评估导致了对基...